Midjourney, DALL-E, Stable Diffusion, Craiyon… ogromny postęp technologii sztucznej inteligencji w ostatnich miesiącach spowodował wysyp w mediach społecznościowych tysięcy zdjęć wygenerowanych przez AI. Stworzone dzięki niej hiperrealistyczne obrazy, osadzone w bieżących wydarzeniach, a czasem przedstawiane jako prawdziwe, sieją u odbiorców zamieszanie. Chociaż w chwili obecnej nie dysponujemy narzędziami do skutecznego wykrywania wygenerowanych obrazów, by je rozpoznać warto osadzić zdjęcie w jego kontekście, przyjrzeć się detalom, gdyż, jak radzą eksperci, niespójności w obrazie mogą być znakiem, że mamy do czynienia z wytworem sztucznej inteligencji.

Wpisujemy kilka słów kluczowych i mamy obraz. Na tej zasadzie działa wiele programów sztucznej inteligencji, takich jak Midjourney, DALL-E, Craiyon czy też Stable Diffusion. Narzędzia te są w stanie wygenerować nieskończoną liczbę obrazów z ogromnej bazy danych, która jest stale zasilana przez użytkowników.

Jak je rozpoznać? Wielu internautów używa narzędzi AI do tworzenia dzieł satyrycznych lub artystycznych. Jednakże niektórzy zdecydowali się powiązać obrazy z bieżącymi wydarzeniami politycznymi.

Po wizycie przywódcy Chin w Moskwie sieć zalały fałszywe zdjęcia (m.in. na Facebooku) rzekomo relacjonujące spotkanie Xi Jinpinga z prezydentem Władimirem Putinem na Kremlu 20 marca 2023 roku.

Użytkownicy udostępniali obrazy mające przedstawiać fikcyjne sytuacje, takie jak „aresztowanie” byłego prezydenta USA Donalda Trumpa, czy też chodzącego po ulicach Paryża prezydenta Francji Emmanuela Macrona w czasie protestów przeciwko reformie emerytalnej.

L’#ia#photo a fait des progrès démentiels en très peu de temps, désormais le #fake sera la norme sur les #reseaux, doutez de ce que vous voyez par défaut, plus le choix.#midjourney#midjourneyv5pic.twitter.com/dJoZXGrbRy

— Cryptonoo₿ From 100K to 0 (@Cryptonoobzzzz)

March 19, 2023

O ile większość autorów wygenerowanych przez sztuczną inteligencję obrazów informuje, że obrazy te nie są prawdziwe, to mimo to były one dalej udostępniane już bez tej informacji, a nawet były przedstawiane jako prawdziwe.

Powstały i cały czas są tworzone narzędzia do wykrywania wygenerowanych obrazów, między innymi ten detektor AI, jednak ich skuteczność daleka jest jeszcze od doskonałości, a nawet mogą one wprowadzać w błąd, jak sami przekonaliśmy się wykonując kilka prób dla AFP.

„AI by wygenerować obraz zazwyczaj nie pobierane są poszczególne jego części tylko z jednego zdjęcia. Wykorzystuje się do tego tysiące, a nawet miliony zdjęć i uwzględnia się miliardy parametrów” – powiedział AFP 21 marca David Fischinger, inżynier z austriackiego Instytutu Technologii i specjalista od AI.

„Sztuczna inteligencja miesza obrazy, które ma w swojej bazie danych, dekonstruuje je, a następnie ponownie rekonstruuje zdjęcie, piksel po pikselu, co oznacza, że patrząc na otrzymany render nie zauważymy już różnicy między oryginalnymi obrazami” – powiedział AFP 21 marca Vincent Terrasi, współzałożyciel Draft & Goal, startupu, który uruchomił generowany przez AI detektor treści na potrzeby uniwersytetów.

Dlatego też oprogramowania przeznaczone do wykrywania fotomontaży, w przypadku wygenerowanych przez AI obrazów, będą działać bardzo słabo lub nie będą działać wcale.

Metadane ze zdjęć cyfrowych (rodzaj dowodu tożsamości każdego pliku, zawierający informacje takie jak czas wykonania zdjęcia i jego lokalizację) nie będą pomocne w przypadku wiralnego zdjęcia: „Niestety, nie można się na tym opierać, ponieważ sieci społecznościowe systematycznie kasują te informacje” – powiedziała AFP 23 marca Annalisa Verdoliva, profesor na Uniwersytecie Federico II w Neapolu i ekspert w dziedzinie AI.

Dotrzeć do źródła zdjęcia

Według tych ekspertów jednym ze sposobów na sprawdzenie czy mamy do czynienia z obrazem AI jest dotarcie do oryginalnego źródła i sprawdzenie, czy użytkownik nie zamieścił dodatkowego wyjaśnienia, iż wygenerował obraz, i przy pomocy jakiego narzędzia to zrobił, co jest częstą praktyką.

Trzeba spróbować określić, kiedy obraz był po raz pierwszy opublikowany w sieci.

Można to zrobić stosując metodę odwrotnego wyszukiwania obrazem. Zapisany obraz umieszczamy w jednej lub w kilku różnych wyszukiwarkach, by sprawdzić, czy wcześniej pojawiał się on w sieci. Dzięki tej opcji wyszukiwarka przeszukuje swoją bazę danych, by sprawdzić, czy w jej katalogu znajdują się obrazy podobne do tego, którego szukamy.

Metoda ta pozwoliła ustalić źródło obrazów, które były szeroko rozpowszechniane w mediach społecznościowych, pokazujące byłego prezydenta USA Donalda Trumpa w grupie policjantów w trakcie „aresztowania”. Odwrotne wyszukiwanie obrazem jednego ze zdjęć w wyszukiwarce Google doprowadziło nas do opublikowanego 20 marca 2023 roku tweeta Eliota Higginsa, założyciela grupy śledczej Bellingcat zajmującej się dochodzeniami przy użyciu narzędzi online.

Higgins tłumaczy w wątku na Twitterze, że stworzył całą serię obrazów przy pomocy najnowszej wersji programu Midjourney.

Making pictures of Trump getting arrested while waiting for Trump’s arrest. pic.twitter.com/4D2QQfUpLZ

— Eliot Higgins (@EliotHiggins)

March 20, 2023

Jeśli nie uda nam się dotrzeć do oryginalnego zdjęcia, odwrotne wyszukiwanie obrazem może pozwolić nam odnaleźć obrazy w lepszej jakości, zdarza się bowiem, że zdjęcie zostało wykadrowane, zmodyfikowane lub straciło na jakości w trakcie udostępniania. Im lepsza jakość, tym łatwiej będzie przeanalizować obraz pod kątem ewentualnych niespójności świadczących, że mamy do czynienia z fotomontażem.

Wreszcie, metoda ta ma jeszcze inną ważną zaletę: pokazuje obrazy podobne wizualne. Może to być użyteczne kiedy będziemy chcieli porównać obraz podejrzewany o to, że jest wygenerowany przez AI, z innymi zdjęciami z tej samej sytuacji, ale które pochodzą z wiarygodnych źródeł.

W dniach po spotkaniu Xi Jinpinga z prezydentem Władimirem Putinem na Kremlu, w sieci krążyło nieopisane zdjęcie, na którym widać prezydenta Rosji na kolanach przed chińskim przywódcą.

Włoski dziennikarz David Puente zwrócił jednak uwagę, że widoczne wnętrze na zdjęciu różni się znacznie od wystroju widocznego na innych zdjęciach opublikowanych przez media relacjonujące to wydarzenie, co wzbudziło u niego wątpliwości co do autentyczności obrazu.

Pomocne jest też zapoznanie się z opisem, a także z komentarzami pod daną publikacją, które mogą zasygnalizować, że jest to fotomotaż, lub wskazać, że dana grafika przypomina obraz wygenerowany przez któryś z konkretnych programów AI, np. DALL-E, który znany jest z hiperrealistycznych obrazów, lub przez Midjourney, który specjalizuje się w tworzeniu obrazów z gwiazdami show-biznesu.

A to może zachęcić nas, aby przejść do narzędzia, które wygenerowało obraz i go na nim odnaleźć. Niektóre generatory, takie jak Midjourney, zachowują ślad wymiany między użytkownikami i automatycznym programem, co może pomóc w dotarciu do wygenerowanych zdjęć.

Jeśli jednak nie uda nam się odnaleźć źródła zdjęcia i nie znajdziemy żadnych wskazówek co do jego kontekstu, należy na nie spojrzeć przez lupę.

Analiza obrazu

- Wyszukaj „podpis”

Czasami pewne wskazówki znaleźć można na samym zdjęciu: niektóre serwisy mają zwyczaj umieszczania na swoich obrazach swego rodzaju podpisy. Tak jest w przypadku programu DALL-E, który automatycznie generuje wielokolorowy pasek w prawym dolnym rogu wszystkich swoich zdjęć, czy też programu Craiyon, który w tym samym miejscu umieszcza mały czerwony ołówek.

Uwaga. Należy jednak pamiętać, że nie wszystkie programy AI stosują tego typu oznaczenia, a ponadto mogło ono zniknąć między jednym a drugim udostępnieniem w sieci, gdyż zdjęcie zostało wykadrowane lub przycięte.

- Zwróć uwagę na ziarno zdjęcia

„W razie wątpliwości przyjrzyjmy się jakie jest ziarno zdjęcia, które, na tym etapie rozwoju technologii AI, znacznie różni się od prawdziwych zdjęć” – powiedziała AFP 22 marca Tina Nikoukhah, zajmująca się przetwarzaniem obrazów w laboratorium matematycznym ENS Paris-Saclay.

AFP wypróbowała niektóre darmowe wersje programów AI. Obraz stworzony w programie Stable Diffusion – wygenerowalismy zdjęcie aktora „Brada Pitt w Paryżu” (poniżej, po lewej stronie) – przypomina stylem hiperrealistyczne malarstwo, które cechują silne kontrasty.

Inne wygenerowane zdjęcie, wykonane w programie DALL-E po wpisaniu podobnych słów kluczowych (poniżej po prawej), wygląda bardziej prawdziwie, a zatem trudniej jest, na pierwszy rzut oka, stwierdzić, że jest to obraz stworzony przez AI.

- Znajdź niespójności wizualne

Pomimo oszałamiającego postępu, jaki poczyniła sztuczna inteligencja, w obrazach wygenerowanych przez AI nadal pozostają liczne błędy. I to te niespójności są na obecnym etapie najlepszym sposobem, aby wykryć czy mamy do czynienia z wytworzonym sztucznie obrazem – wyjaśnili nam eksperci.

„Pewne charakterystyczne aspekty, często te same, stanowią problem dla AI i to właśnie te niespójności i artefakty należy przeanalizować, jak w dziecięcej zabawie «znajdź różnice»” – wskazuje Vincent Terrasi.

„Jednak programy AI nieustannie są udoskonalane i w ich obrazach pojawia się coraz mniej błędów, więc na dłuższa mętę nie będzie można polegać na zauważalnych niespójnościach wizualnych” – zauważa Annalisa Verdoliva.

W chwili obecnej, w marcu 2023 roku, programy te mają problem ze stworzeniem m.in. prawdziwie wyglądąjąch dłoni. Nieproporcjonalne palce Brada Pitta widać na wygenerowanym przez AFP obrazie (powyżej, po lewej stronie.)

Innym przykładem jest zdjęcie udostępnione na całym świecie, również w Polsce i zweryfikowane już przez AFP, przedstawiające papieża Franciszka w długim, modnym białym płaszczu puchowym.

Jego lewa ręka na obrazie jest nienaturalna, a niektóre elementy są rozmyte i bardzo płaskie, co może wskazywać, że jest to obraz wygenerowany przez sztuczną inteligencję.

Jedno z pierwszych udostępnień obrazu można znaleźć na Reddicie w publikacji z 24 marca.

Platforma internetowa BuzzFeed (link zarchiwizowany tutaj ) wyjaśniła w artykule z 27 marca, że skontaktowała się z twórcą obrazu, niejakim Pablo Xavierem z Chicago, który wyjaśnił, że stworzył obraz dla „zabawy”.

Na serii zdjęć, rzekomo wykonanych podczas protestów przeciwko reformie emerytalnej w Paryżu 7 marca 2023 roku ukazujących funkcjonariusza sił porządkowych obejmującego demonstrantkę, dziennikarz AFP zauważył, że policjant ma sześć palców, co dowodzi, iż obraz został wygenerowany.

The hand strikes again: these photos allegedly shot at a French protest rally yesterday look almost real – if it weren’t for the officer’s six-fingered glove #disinformation#AIpic.twitter.com/qzi6DxMdOx

— Nina Lamparski (@ninaism)

February 8, 2023

Na niektórych wygenerowanych zdjęciach z rzekomego brutalnego aresztowania Trumpa twarze wielu policjantów są niewyraźne, a ręce i stopy funkcjonariuszy pojawiają się w niewłaściwych miejscach. Na jednym z nich widać też Donalda Trumpa, która ma na sobie policyjny pasek od spodni.

„Na tym etapie rozwoju nowej technologii, programy AI mają też spore problemy z wygenerowaniem refleksów, np. odbicia światła na wodzie. Szukanie cieni, luster, wody, ale także powiększanie oczu i analizowanie źrenic, to też dobry sposób na wykrywanie obrazów AI. Kiedy robimy komuś zdjęcie, zwykle w jego oczach pojawia się odbijające się światło. Często możemy też zauważyć, że oczy nie są tej samej wielkości, czasem mają różne kolory” – podkreśla Terrasi.

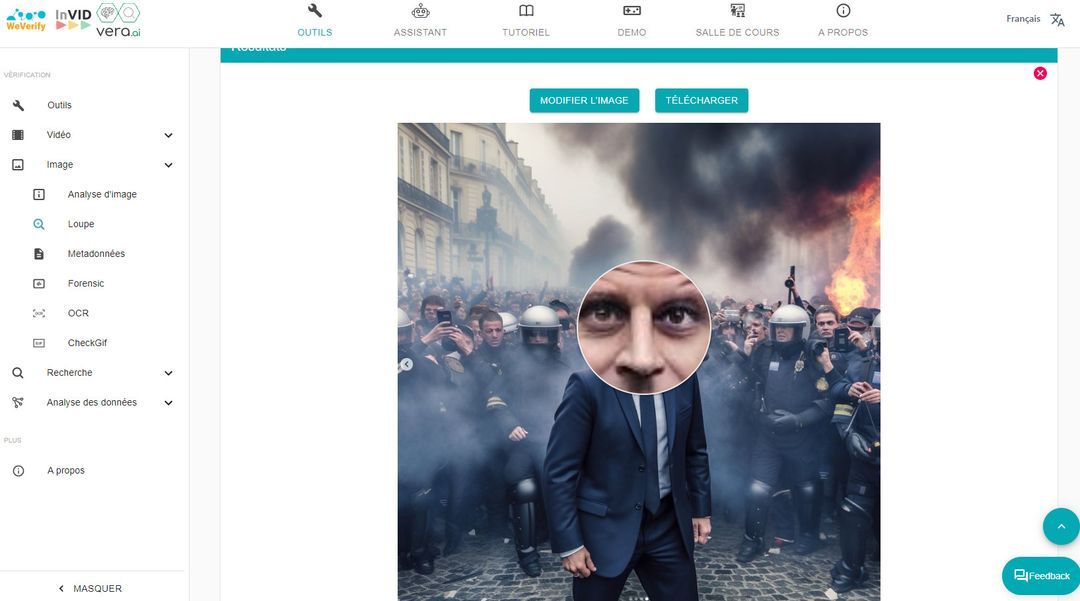

Tak jest w przypadku wygenerowanego przez AI zdjęcia Macrona udostępnionego na Instagramie. Fragment twarzy obejrzeliśmy pod lupą, korzystając z funkcji „szkła powiększającego” dostępnego w narzędziu Invid-WeVerify i zauważyliśmy, że oczy są brązowe, a nie niebieskie. Co więcej, odcień brązu jest różny w przypadku każdego oka.

Programy generują często asymetryczne obrazy, w których twarz jest nieproporcjonalna, uszy są na różnych wysokościach, a na jednym brak np. kolczyków…

Zęby i włosy również są trudne do wygenerowania i po nich można poznać, że obraz jest fikcyjny.

Niektóre elementy mogą być też źle wkomponowane, jak np. okulary przeciwsłoneczne, które niejako wtapiają się w twarz.

Wreszcie, wytworzenie obrazu poprzez poskładanie wielu zdjęć może powodować problemy z oświetleniem, podkreślają eksperci.

- Analiza drugiego planu na zdjęciu

Warto zauważyć, że niespójności pojawiają się czesto na drugim planie zdjęcia.

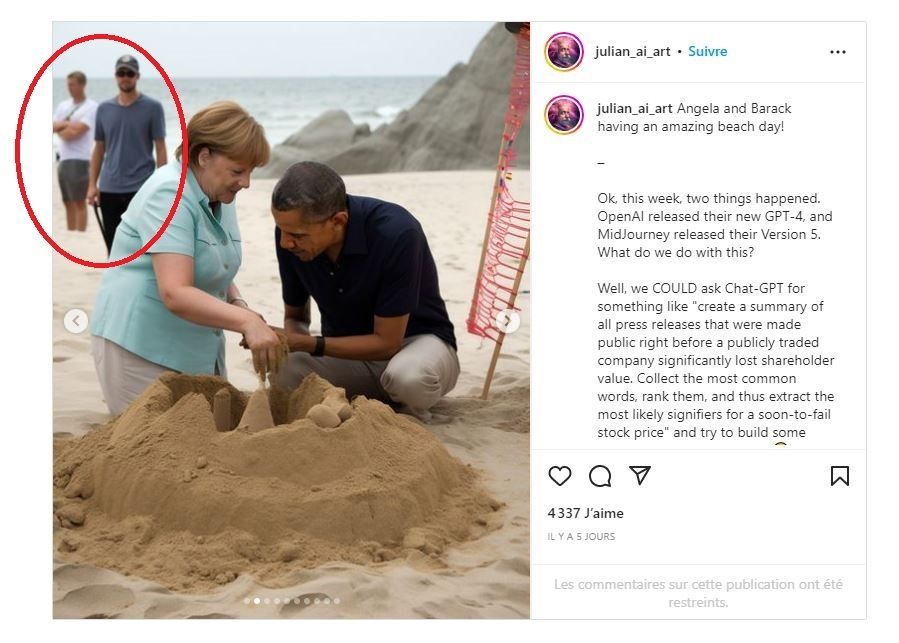

Na zdjęciach Baracka Obamy i Angeli Merkel na plaży, na pierwszy rzut oka wyglądających na prawdziwe, i które krążą w mediach społecznościowych, na drugim planie jedna z osób ma odcięte nogi, co zdradza, iż zdjecie jest wygenerowane.

„Im bardziej oddalony jest jakiś element, tym bardziej będzie rozmyty i zniekształcony, i tym bardziej nieprawidłowa będzie perspektywa” – dodaje Terrasi.

Na fałszywym zdjęciu ze spotkania Xi Jinpinga i Władimira Putina pionowa linia kolumny w tle nie jest prosta – to jedna wskazówka. Ponadto głowa Władimira Putina jest nieproporcjonalnie duża w porównaniu do reszty ciała, co zdradza, że obraz został wygenerowany przez AI – wskazuje nam Fischinger.

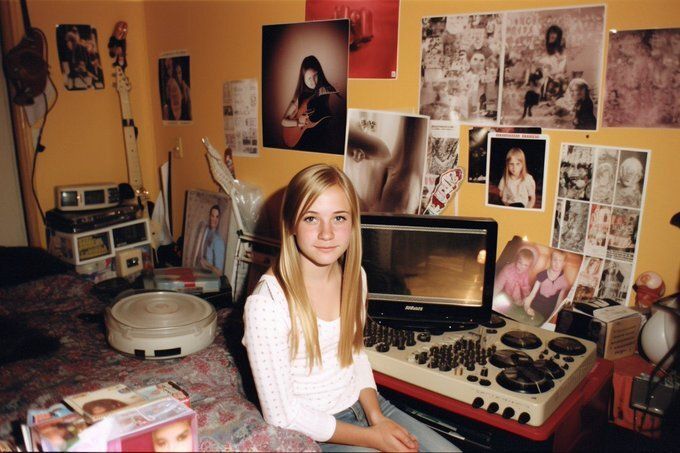

Innym przykładem jest ten obrazek przedstawiający nastolatkę w jej pokoju. Na pierwszy rzut oka nic nas nie dziwi. Jeśli jednak przyjrzymy się bliżej by zobaczyć co jest na drugim planie, znajdziemy wiele dziwnych rzeczy i niespójności: przedmioty, których nie sposób zidentyfikować, a przede wszystkim zniekształcone twarze na niemal wszystkich plakatach na ścianie.

- Kieruj się zdrowym rozsądkiem

Podczas gdy niektóre elementy nie są koniecznie zniekształcone, mogą jednak zdradzać błąd logiczny, a „dobrze jest kierować się zdrowym rozsądkiem”, gdy ma się wątpliwości co do obrazu – kontynuuje ekspert.

Na tym zdjęciu, wygenerowanym przez AFP na DALL-E, i rzekomo przedstawiającym Paryż, widać na przykład niebieski znak zakazu ruchu, model oznakowania, który po prostu nie jest we Francji używany.

Ten fragment a także odcięty palec, plastikowy croissant i różne odbicie światła w oknach wskazują, że ten obraz jest dziełem sztucznej inteligencji. Znak wodny w prawym dolnym rogu obrazu dowodzi ponad wszelką wątpliwość, że obraz został stworzony przez firmę DALL-E.

Dodatkowo, chociaż obraz stworzony na potrzeby tego przykładu miał przedstawiać Brada Pitta, wynik jest wątpliwy pod względem podobieństwa do aktora.

Wreszcie, jeśli zdjęcie rzekomo przedstawia jakieś wydarzenie, ale istnieją wątpliwości co do jego źródła, najlepszą metodą jest wyszukanie informacji, aby sprawdzić, czy inne wiarygodne źródła relacjonowały to samo wydarzenie i czy rzeczywiście miało ono miejsce, a jeśli tak, zestawić te obrazy, aby sprawdzić czy nie występują w nich niespójności.

W przypadku spotkania dwóch przywódców politycznych mogą to być na przykład takie szczegóły jak ich ubiór, okoliczności wydarzenia, ówczesna pogoda, sceneria lub obrazy tłumu w tle.

W przypadku spotkania dwóch przywódców politycznych mogą to być na przykład takie szczegóły jak ich ubiór, okoliczności wydarzenia, ówczesna pogoda, sceneria lub obrazy tłumu w tle.